Az OpenAI O4-Mini hatékony és gyors következtetésre készült, különös fókuszszal a szöveges és képi bemenetek feldolgozására. Ideális olyan feladatokra, amelyek nemcsak szöveges adatok elemzését, hanem vizuális tartalom értelmezését is igénylik. A modell képes képek felismerésére és azok összekapcsolására szöveges leírásokkal, így alkalmazható például videók automatikus elemzésében, képek leírásának generálásában vagy akár generatív design területen, ahol képi és szöveges információkat kell kombinálni.

Az o3-mini modell

Az O4-Mini modell fő jellemzői

1. Multimodális következtetés

Az O4-Mini multimodális következtetést használ, ami azt jelenti, hogy egyszerre képes szöveget és képeket feldolgozni. Ez a képesség kulcsfontosságú olyan alkalmazásoknál, ahol különböző adatformátumok összekapcsolása szükséges. Az O4-Mini nemcsak a szöveget elemzi, hanem a vizuális tartalmat is értékeli, így ideális például képleírások generálásához, vizuális anyagból szöveg előállításához és hasonló feladatokhoz.

2. Javított képfelismerés

Az O4-Mini egyik fő előnye a képfelismerés továbbfejlesztett képessége. A korábbi verziókhoz képest javított algoritmust használ objektumdetektálásra, képtartalom-elemzésre és szöveges leírások generálására. Ez erős segítséget jelent videóelemzésben, arcfelismerésben, jelenetfelismerésben és képleírások készítésében.

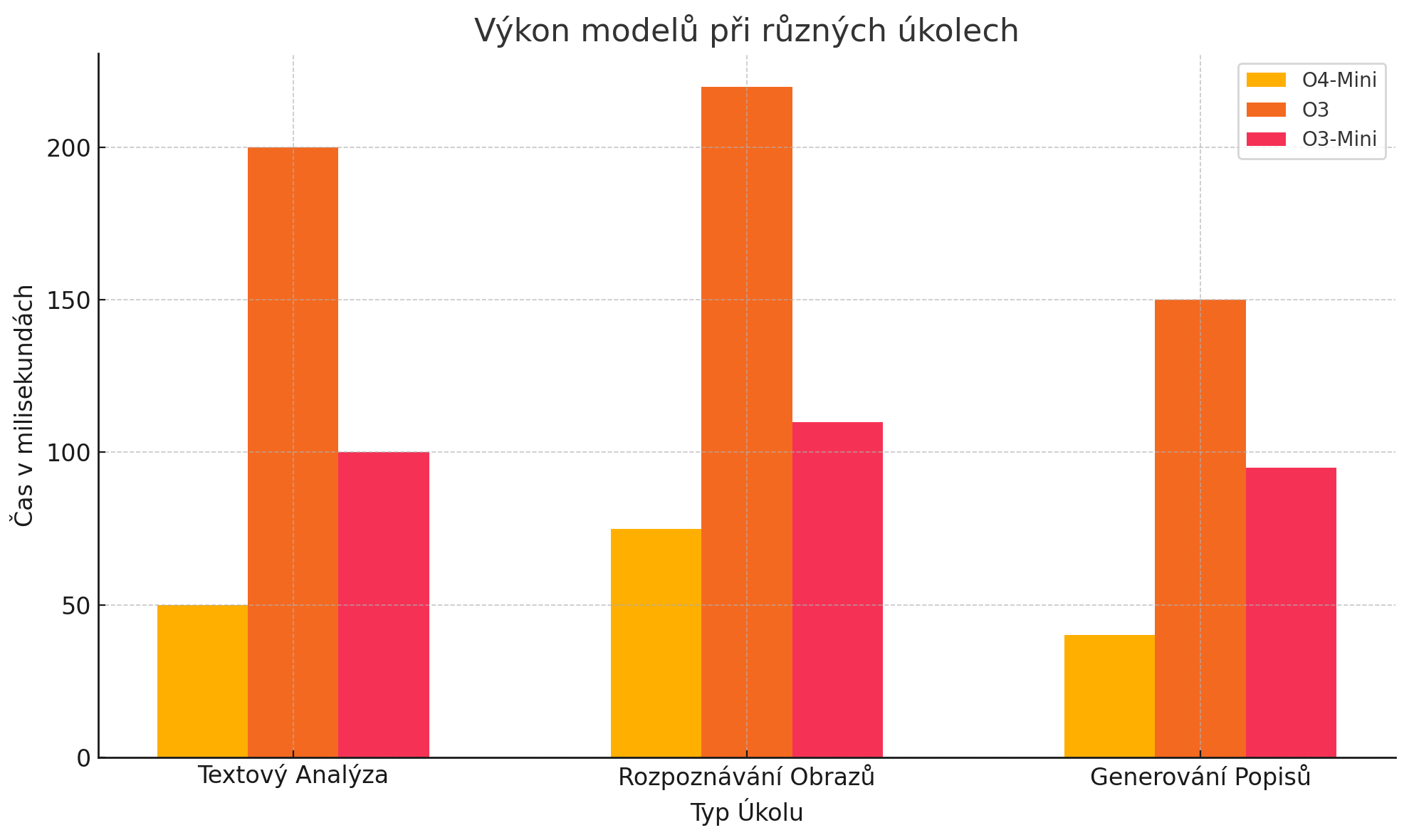

3. Sebesség és hatékonyság

Az O4-Mini nagy adathalmazok gyors feldolgozására optimalizált. A számítási erőforrások hatékony kihasználásának köszönhetően összetett feladatokat is jelentős lassulás nélkül kezel. A bemeneti tokenek maximális hossza 200 000, a kimeneti tokenek maximuma 100 000. Ez a modell kiváló eszköz gyors és pontos adatértékeléshez (Unite.AI, 2025).

4. Kedvező árazás

Az O4-Mini használati ára rendkívül versenyképes. 1 millió bemeneti token ára 1,10 USD, ami alacsonyabb más modellekhez viszonyítva. Például az O3 modell 10,00 USD-t kér 1 millió tokenért. Ez az árazás kedvező a cégek és fejlesztők számára, akik valós idejű szöveg- és képfeldolgozáshoz költséghatékony eszközt keresnek (TechFeed, 2025).